Introduction

-

Publics ciblés :

Collégiens

-

Thématiques :

Éducation musicale, Sciences de la vie et de la terre, Technologie

Objectifs

-

1

Comprendre comment les technologies influencent notre manière d’écouter la musique (diffusion, compression, miniaturisation des formats de stockage du son)

-

2

Connaître l’histoire des courants musicaux : les influences et ruptures

Compétences de l'élève

-

Ecouter de manière sélective les sons qui l’entourent

-

Repérer les sons liés à la technologie

-

Chercher les informations pertinentes (CDI, Internet, etc.)

-

Travailler en groupe

-

Rédiger un guide d’entretien

-

S’estimer et être capable d’écoute et d’empathie

-

Utiliser les ressources numériques

-

Exercer son esprit critique

-

Réaliser une production multimedia

-

Réaliser et présenter un exposé

Activites proposées

- Recherches documentaires : l’histoire des musiques amplifiées, l’évolution des technologies d’écoute et de pratiques musicales, les intensités moyennes des instruments de musique

- Visite d’une salle de musique actuelle : comprendre le fonctionnement de la sonorisation en concert

- Le son est-il le même selon le lieu (salle, sur scène, fosse) ?

- Préparer un guide d’entretien pour bien comprendre le rôle des professionnels (techniciens, sonorisateur...)

Éléments de connaissances et pistes de réflexion

Technologie

Quelques repères technologiques inspirant les courants musicaux

Les procédés d’amplification du son et l’apparition des supports d’enregistrement ont contribué aux changements des pratiques musicales et d’écoute de la musique. C’est l’invention du téléphone (traitement électrique du son) et de la machine permettant d’enregistrer le son qui va être le point de départ de ces bouleversements.

La création musicale et les différents courants musicaux se sont emparée au fil du temps de ces nouvelles technologies (mécanique, électrique, électronique, numérique) pour offrir aux spectateurs et aux auditeurs de nouvelles perspectives musicales.

– L’électricité va permettre la création du telharmonium et du dynamophone (énorme machine de plusieurs tonnes) dont le principe est basé sur le courant alternatif où un ensemble de dynamos commande des haut-parleurs et génèrent des sons sinusoïdaux. A la fin du 19ème siècle, il était possible de recevoir de la musique sur le réseau téléphonique en s’abonnant.

– De l’électricité à l’électronique, ce pas est franchi grâce à l’invention de la lampe à triode ou Audion (1906) qui sera à l’origine de la création du Theremin Vox ou Aetherophone. En variant la position de la main par rapport à l’antenne cela modifie la fréquence d’oscillations électriques produites et donc la hauteur de la note. Clara Rockmore, virtuose de cet instrument jouera même « la Vocalise » de Rachmaninov. Les ondes Martenot constituent aussi l’un des plus anciens instruments de musique électronique. Il se caractérise par ses sonorités particulières, dont la plus connue, proche de la sinusoïde, évoque des voix « venues d’ailleurs ».

– La radio découverte dans les années 30 va aussi bouleverser l’histoire de la musique.

C’est en 1939 que l’enregistrement voit le jour. Pour la première fois une pièce est réalisée sur un support il s’agit de « Imaginary landscape n°1 » de John Cage.

L’enregistrement va engendrer de nouvelles façons de composer la musique et de jouer grâce aux nouveaux appareils qui fixent le son comme le tourne-disque ou plus tard les échantillonneurs.

– Après la seconde guerre mondiale, les studios de production et de radiodiffusion voient le jour. En France, Pierre Schaeffer (1948) va enregistrer des bruits pour en faire un matériau sonore (« Etude aux chemins de fer » ; « Symphonie pour un homme seul ») et Stockausen (« Studie 1 » et « Studie 2 ») en Allemagne qui donnera naissance à la musique électronique. Deux écoles fusionneront pour créer la musique électroacoustique qui se répandra dans toute l’Europe et les Etats-Unis.

– La musique électronique « live » se joue en direct sur scène (Ferrari, Morricone) grâce à des appareils de mixage et d’amplification, des instruments de synthèse et des outils de

traitements sonore

– L’arrivée de l’ordinateur dans les années 50 va permettre le passage de l’ère de l’électronique à celle du numérique, bouleversant les codes musicaux. En 1957, Max Mathews réalise un programme permettant de générer des sons de synthèse. Grâce à des algorithmes et à un grand nombre de combinaison, de modules chacun peut composer sa propre partition. L’ordinateur n’est alors accessible que pour les studios, les centres de recherche.

La création des compositeurs restent dépendante des performances de calculs des ordinateurs qui sont à leurs débuts.

L’enregistrement progresse avec le magnétophone qui permet les opérations de montage et de traitement du son.

Dans les années 80, les synthétiseurs numériques (DX7 à synthèse FM) donnent la possibilité de programmer et de sauvegarder des sons synthétisés. Pour la première fois, ils deviennent accessibles au grand public. De nouveaux constructeurs vont investir le marché et la norme MIDI (musical interface for digital instruments) permettra de connecter et de rendre compatibles des instruments et outils de marque et de fabrication différent.

Parallèlement, de nouveaux instruments voient le jour grâce à la synthèse sonore : les boîtes à rythme, les échantillonneurs, les batteries électroniques, guitares et saxophones MIDI… Ces interfaces hommes-machine ouvrent des possibilités jusque-là inégalées en convertissant et transmettant des informations gestuelles, énergétiques et physiques.

Durant cette même période l’ordinateur se démocratise et entre dans les foyers…

– L’ordinateur va remplacer les outils électroniques (MIDI, expander, sampler ou processeur d’effets). L’institut de Recherche et de coordination acoustique-musique (IRCAM) dirigé par Pierre Boulez milite pour la musique instrumentale en « temps réel » avec les capacités que nous offrent les technologies actuelles. Le logiciel MAX est une application modulaire offrant à son utilisateur l’opportunité de fabriquer lui-même ses programmes avec des interfaces où les capteurs électroniques sont capables de convertir les informations physiques de l’environnement réel en données numériques.

De l’enregistrement à la compression de fichiers audio

La compression audio vise à réduire la quantité de données pour stocker la musique. Dans un format donné, les fichiers sont déclinés en plusieurs taux de compression (bitrate exprimé en kbps) qui induisent des niveaux de qualité sonore et des poids de fichier très différents

Deux formats de compression sont possibles : la compression sans pertes de données (fichiers Wav) et la compression avec perte de données (MP3, VQF, OGG, VORBI).

Education musicale

Dans les années 30, la guitare électro-amplifiée trouve sa place à côté de la batterie ou des cuivres. Le blues (musique noire américaine), la country (musique blanche américaine inspirée par la musique folklorique européenne) et le jazz s’emparent très vite de ce progrès technique. Les premières guitares électrifiées sont de simples guitares acoustiques munies d’un micro placé sous les cordes. A cette époque, sur scène, l’amplification reste assez sommaire même si les constructeurs commencent à fabriquer des “ampli guitare”. L’un des premiers musiciens à électrifier sa guitare s’appelait Charlie Christian, guitariste de jazz auprès de Benny Goodman et précurseur du be-bop.

Dans les années 50, le rhythm & blues, popularisé par les big bands de jazz et de boogie, commence à séduire de plus en plus de jeunes Blancs américains conquis par les nouvelles danses effrénées auxquelles ils s’adonnent dans les clubs.

C’est dans ce contexte de libéralisation des moeurs que le rock & roll voit le jour. Très vite, la jeunesse américaine avide de liberté s’empare de cette musique. Il s’agit de la première musique populaire créée par et pour les jeunes et qui dépasse les clivages de couleurs. On fixe traditionnellement l’avènement du rock en 1954 avec le titre “That’s All Right Mama” d’Elvis Presley.

La basse électrique vient aussi concurrencer la contrebasse dans un souci de recherche de volume sonore.

Avec la radio puis la télévision et la démocratisation du disque vinyle, la musique entre dans les foyers.

Dans les années 60, la soul music, inspirée du gospel, se popularise y compris en Europe. Cette musique noire américaine représente la communauté par opposition au blues qui symbolise plutôt l’individu. Elle est incarnée par des artistes comme Otis Redding, Aretha Franklin ou Ray Charles. La puissance sonore émerge à des fins esthétiques et de révolte.

Le rock arrive en Angleterre et donne naissance au pop rock (les Beatles, les Kinks, les Animals ou bien encore les Rolling Stones). A cette époque, les constructeurs d’amplis développent une nouvelle génération de matériel de très forte puissance (Marshall).

L’apparition des pédales d’effets permet aux musiciens de créer de nouvelles sonorités avec notamment l’effet “distorsion” (guitare saturée) et l’effet wha wha rendu célèbre par Jimi Hendrix.

Des artistes comme les Pink Floyd ou Frank Zappa tiennent encore aujourd’hui une place à

part aujourd’hui pour leurs célèbres expérimentations sonores. La naissance du synthétiseur va permettre aussi d’enrichir les palettes sonores des musiques amplifiées. Le rock se diversifie et la recherche du volume sonore développe de nouvelles sensations, les

niveaux sonores sont alors parmi les plus importants pendant les concerts.

Les évolutions technologiques en matière de sonorisation de concert permettent de sonoriser des espaces de plus en plus vastes. C’est l’époque des premiers gros festivals qui rassemblent, pour la première fois, des milliers de personnes autour de la musique (festival de Woodstock-USA, festival de l’Ile de Wight-Angleterre 1970 et festival d’Amougie- Belgique durant l’année 1969). Ces événements participent à l’essor des stars du rock.

Dans les années 70, les progrès techniques étant de plus en plus complexes, le sonorisateur va gérer les murs de son que l’on installe dans les concerts face au public.

Dans le même temps, le synthétiseur se généralise et permet une diversification des courants musicaux autour du rock planant (Pink Floyd, Vangelis, Can, Tangerine Dream, Kraftwerk…), du disco (Donna Summer, Village People, Boney M…) puis la new wave (Joy Division, The Cure, Depeche Mode…).

Au début des années 70 en Jamaïque, le reggae donne naissance au dub. Ces nouvelles versions sont utilisées dans les sound system (sorte de disco mobiles) par le selecter (nom donné au Dj jamaïcain : celui qui passe les disques). Avec le rap, les Dj’s commencent à chanter de façon très rythmée et saccadée sur les versions instrumentales et utilisent la technique du scratch (manière de jouer sur la vitesse de rotation d’un disque vinyle).

Parallèlement, une économie musicale se met en place avec la naissance d’écoute nomade (walkman, miniK7) avec casque. Le temps quotidien d’écoute de musique va s’accroître rapidement.

Au début des années 80 en Jamaïque, lors des sound system, les Dj’s commencent à reprendre le principe du rap américain en utilisant des versions instrumentales de reggae digital. Très vite, leur façon de chanter (toaster) se démarque du phrasé rap : c’est la naissance du raggamuffin.

Le sampler ou échantillonneur (1984) va permettre l’enregistrement d’un thème musical écouté en boucle pour en faire un nouveau morceau.

Parallèlement, les premiers ordinateurs (les Atari) permettent de créer de la musique électronique inspirée par Vangelis ou Kraftwerk. Le sampler est très utilisé dans le rap, les musiques électroniques mais aussi désormais dans tous les styles musicaux.

En 1985, le disque compact (CD) devient le premier support d’écoute numérique grand public qui reste aujourd’hui la référence. En 1995, le format MP3 (format de compression des fichiers musicaux) permet à la musique de s’exporter et d’évoluer. L’ordinateur est devenu à lui tout seul un instrument de musique (il permet la création de son), un studio d’enregistrement (il permet l’enregistrement et le traitement numérique du son) et un support d’écoute (grâce notamment au baladeur MP3). Internet permet aussi à la musique de voyager, de se métisser et, ainsi, de sans cesse évoluer.

Le développement de nouvelles technologiques a contribué à l’augmentation considérable du volume sonore dans les divers lieux d’écoute ou de pratiques musicales. Ce n’est pas un épiphénomène mais un véritable phénomène de société à la recherche de toujours plus de

puissance acoustique !

Nos oreilles sont soumises aujourd’hui à des niveaux sonores inégalés par la multiplication des techniques d’amplification, des lieux et des modes d’écoute à fort volume (concerts, discothèques, rave parties, locaux de répétition, écoute du baladeur, chaîne hi-fi, autoradio…).

Le risque d’altération prématuré de l’audition constitue un véritable problème sociétal.

Sciences de la vie et de la terre

L’OMS estime que plus de 1,1 milliard de jeunes à travers le monde pourraient courir un risque de perte auditive due à des habitudes d’écoute dangereuses. Plus de 43 millions de personnes de 12 à 35 ans souffrent d’une perte auditive invalidante due à différentes causes.

360 millions de personnes dans le monde souffrent de déficience auditive incapacitante.

La déficience auditive peut être due à des causes génétiques, à des complications à la naissance, à certaines maladies infectieuses, à l’utilisation de certains médicaments, à l’exposition à un bruit excessif ou au vieillissement.

La moitié des cas de déficience auditive pourraient être évités par la prévention primaire.

Les personnes atteintes de déficience auditive peuvent voir leur état amélioré par l’utilisation de dispositifs tels que les appareils auditifs, les dispositifs d’aide à l’audition et les implants cochléaires, de même que par le sous-titrage, la formation à la langue des signes et d’autres formes de soutien éducatif et social.

La production actuelle de prothèses auditives répond à moins de 10% des besoins sur le plan mondial.

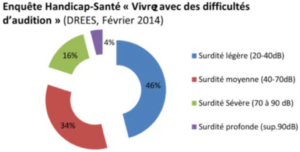

L’audiogramme pour évaluer l’atteinte auditive

A la naissance, nous ne possédons que 15000 cellules auditives ciliées par oreille pour 135

millions de cellules visuelles… Il n’existe pas chez l’homme de régénération naturelle des

cellules ciliées détruites : l’atteinte est irréversible ! Nos oreilles n’étant pas protégées, comme nos yeux, par des paupières, elles fonctionnent 24 heures sur 24 !

La surdité ne signifie pas ne plus rien entendre, mais entendre moins bien, ne plus comprendre ce qui est dit, devoir faire répéter certaines phrases.

La norme NF S 30.105 définit la surdité ou déficience auditive comme une perte d’audition liée à une déficience du système auditif. C’est une baisse de l’audition temporaire ou définitive.

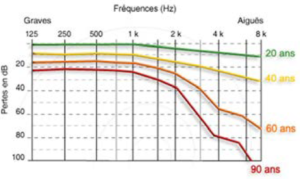

Pour mesurer la capacité de l’oreille à détecter les sons selon la fréquence, on évalue les seuils auditifs. L’audiométrie tonale utilise des sons purs et teste 8 à 9 fréquences. La méthode Audioscan permet d’obtenir des audiogrammes plus précis car elle teste 64 fréquences par octave en utilisant un procédé de balayage différent.

Les audiogrammes sont comparés aux audiogrammes de référence pour l’âge et le sexe.

Au-delà de l’exposition au bruit, la surdité de transmission peut résulter des séquelles d’otites chroniques. Elle touche l’oreille moyenne et l’oreille externe et ne peut jamais être totale. Elle peut être récupérée partiellement ou totalement (médicaments, chirurgie…).

La surdité de perception touche l’oreille interne, la cochlée et le nerf auditif et ne peut pas être soignée par voie médicamenteuse. Elle peut être efficacement corrigée par des aides auditives (prothèses, implants….). Elle a pour cause une malformation ou des dommages aux cellules ciliées de l’oreille interne.

La surdité congénitale est présente à la naissance et peut être héréditaire ou génétique, ou bien résulter d’une maladie ou de dommage s’étant produit au cours du développement foetal. L’incidence de la surdité congénitale est estimée à 2-5 cas pour 1000 naissances et est généralement permanente.

La surdité acquise se produit après la naissance, résultant d’une maladie ou d’un traumatisme. Lorsque la perte d’audition se produit avant l’acquisition du langage chez l’enfant (environ 2 ans ½), il s’agit d’une surdité pré-linguale. Après l’acquisition du langage, il s’agira d’une surdité post-linguale. Elle a pour origine : l’exposition à des niveaux de bruits trop importants qui endommage définitivement les cellules ciliées de l’oreille interne, des traumatismes comme un traumatisme crânien résultant d’un accident, des maladies comme une méningite ou une maladie auto immune, certains médicaments, qualifiés alors d’ototoxiques (antibiotiques : aminosides) et l’âge, qui chez certaines personnes, entraîne une perte progressive de l’audition que l’on appelle la presbyacousie.

Le seuil d’audibilité est fixé à 0 dB(A) et celui de la douleur de l’oreille se situe à 120 dB(A).

Les risques auditifs sont liés à la « dose de son » reçue par l’organisme c’est-à-dire l’intensité sonore associée à une durée d’exposition.

La réglementation européenne sur le bruit au travail recommande de ne pas dépasser « les doses » suivantes :

85 dB(A) → 2h32

88 dB(A) → 1H16

91 dB(A) → 38 min

100 dB(A) → 5 min

105 dB(A) → 1,30 min

110 dB(A) → 30 s

Lorsque nous sommes exposés à plus de 80 dB(A) 8 heures par jour, une fatigue auditive s’installe progressivement. Associée à des bourdonnements ou des sifflements d’oreilles (acouphènes), elle est le signe annonciateur d’une perte d’audition.

Cette perte d’audition est insidieuse dans la mesure où les effets observés ne sont pas immédiats mais elle est irréversible car les cellules de l’oreille interne qui sont atteintes ne se renouvellent pas. La personne malentendante va peu à peu s’isoler de son entourage qu’elle n’arrive plus à comprendre.

Attention : une seule exposition à des niveaux sonores très élevés (100 dB(A) et plus) peut provoquer un traumatisme sonore aigu, au travail comme dans les loisirs (concerts, discothèques, stand de tirs, karting…).

Les symptômes

La fatigue auditive est une élévation temporaire des seuils d’audition, de l’ordre de 5 à 10 dB. Elle constitue un signal d’alarme. Si l’expérience se renouvelle trop souvent, la surdité s’installe progressivement.

Les traumatismes sonores aigus (TSA) sont dus à l’exposition à un bruit de courte durée et d’intensité importante, engendrant une diminution de l’audition (exemples : détonations d’arme à feu, explosions, pétards…)

Les acouphènes sont des bruits « parasites » dans l’oreille, alors que rien dans l’environnement ne génère ce type de son. Ils peuvent provoquer des troubles du sommeil, de l’irritabilité, des troubles de la concentration etc. Lorsqu’ils sont forts et constants, ils peuvent devenir intolérables et conduire à la dépression.

L’hyperacousie est le fait d’entendre les sons plus forts qu’ils ne le sont vraiment, ce qui provoque une intolérance au bruit. Cela entraîne un isolement des personnes atteintes. La réadaptation aux sons forts doit être très progressive accompagnée d’une thérapie comportementale et d’exercices de relaxation.

Pertes auditives moyennes selon l’âge

En dehors de toute exposition aux bruits, l’audition diminue naturellement avec l’âge.

Les moyens de prévention

Le premier moyen de prévention des lésions auditives consiste à prendre conscience que, d’un point de vue physiologique, « la dose de bruit » correspond à la combinaison de deux valeurs : l’intensité sonore (en décibels) d’une part et le temps d’exposition d’autre part.

Si la dose de bruit maximale admissible tend à être de mieux en mieux respectée dans le monde du travail, les expositions sonores de loisir ne sont jamais prises en compte alors, qu’elles sont souvent très importantes, notamment dans les loisirs musicaux.

Le deuxième moyen de prévention est d’apprendre à limiter son temps d’exposition personnel et à s’éloigner des sources sonores quand la dose maximum est atteinte, ou de s’en protéger par des bouchons d’oreille si l’on souhaite ou si l’on doit rester sur le lieu de l’exposition sonore.

Le troisième moyen de prévention est d’être particulièrement vigilant sur les quelques « signaux » d’alerte envoyés par notre organisme (acouphènes temporaires, fatigue auditive…) car il n’y a que très peu de récepteurs de la douleur dans l’oreille pour nous avertir d’une atténuation auditive graduelle.

Le dernier moyen de prévention est de connaître les mesures d’urgence à adopter en cas de surexpositions traumatisantes pour en « limiter » les conséquences : consulter dans les 24 heures un service d’urgence ORL.

Aller plus loin

- Sites internet

-

Vidéos

C’est pas sorcier – Fred & Jamy : Coulisses d’un concert- (26min) Orchestre National de Lyon : Les coulisses d’un concert : Les ondes Martenot Le fonctionnement de l’oreille - Université libre de Bruxelles Le système auditif - Polyclinique de l’oreille : 2’37 – Extrait : 0 à 1’17 Physiologie de l’oreille : DVD Hein ! (AGI-SON) Perte des cellules ciliées Le bruit et les jeunes : ESET 2min tout compris : 2’36 La déficience auditive dans la vie courante Film « La famille bélier » (2014) d’Eric Lartigau Les moyens de protection 1/2 : Santé Publique France Les moyens de protection 2/2 : Institut National de Recherche et la Sécurité Documentaire Arte – « La magie du son » Documentaire de Anne Lévy-Chambon « Pourquoi tant de bruit ? » juin 2016 -52 min

-

Applications mobiles

> APPLICATIONS MOBILES POUR TESTER L’AUDITION Siemens test auditif Entendre Mimi test Hearing check, appli en anglais > APPLICATIONS MOBILES DE SONOMETRES dB Live JNA Decibel X Decibel Meter Decibels Ambiciti : l’application la plus élaborée : mesure individuelle et collective de la pollution sonore, NoiseLevel

-

Ouvrages, guides, Articles

CIDB « Bruit et santé » 21 pages Rapport ADEME/ CNB (2016) « Le coût social du bruit » Meursault, P. (2015). Phonographies, transmissions, plasticités sonores. POLI, n°11, p97-119. Qualité sonore : Traitements et mauvais traitements : que vaut la musique que l’on écoute ? Hannecart, C, Crusson, N, Fourrage, H (2015) « Rapports des jeunes à la musique à l’ère numérique. Synthèse de l’enquête menée en Pays de la Loire » Le Pôle, 24 pages Le développement de l'industrie musicale en Grande-Bretagne de l'entre-deux-guerres aux années Beatles : une trajectoire d'innovation globale ? JNA Livre blanc « Des oreilles pour la vie, un enjeu de santé publique » Un regard pluridisciplinaire sur la santé auditive des jeunes en France Liberman, C (2016). « Le fléau des pertes auditives cachées » Pour la science, n°461. P59-65 Sterne, J. (2015). Une histoire de la modernité sonore. La rue musicale, La Découverte. 504 pages